VectorVein-无代码AI工作流程序

VectorVein-无代码AI工作流程序

noise介绍

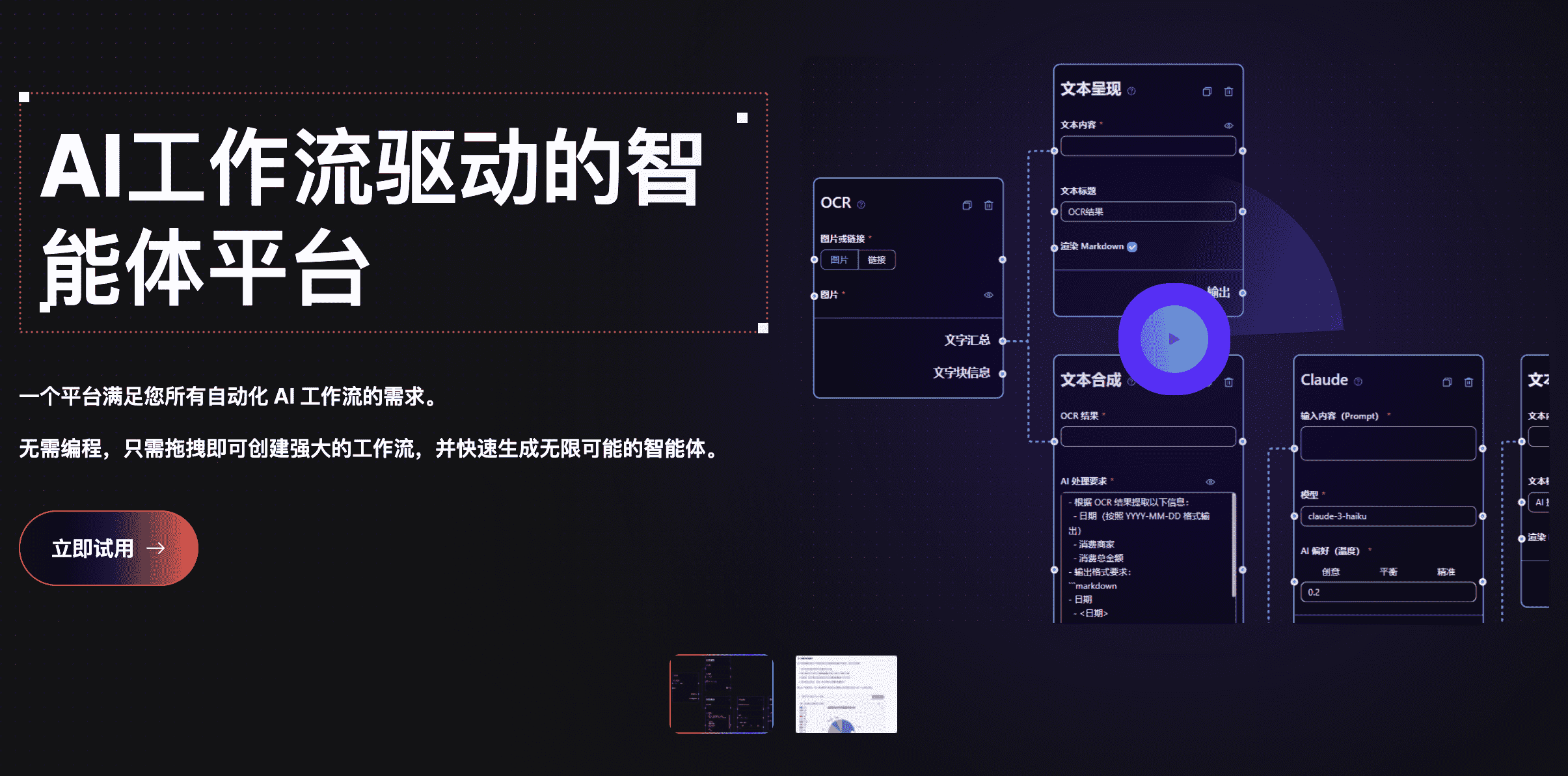

向量脉络是一个结合了 AI 的无代码工作流平台,可以通过简单的拖拽,结合自己的日常工作、业务流程,快速构建出自己的 AI 应用,实现你的私人订制 AI 生产线

通过邀请链接可获得 2000 积分奖励:https://vectorvein.ai/user/register?ref=b460gz

Github:https://github.com/AndersonBY/vector-vein

特征

智能体聊天

不满足于单个工作流的能力?你可以赋予智能体多个工作流,在与智能体聊天中让 AI 帮你判断并运行工作流

图形化设计

无需代码编程,只需拖拽工作流节点并按照您的需求进行逻辑连接即可快速创建强大的工作流。

有编程基础还想进一步扩展功能?我们提供了自定义编程节点,让您可以自由发挥!

工作流应用

工作流效果不错想让朋友试试?通过秘钥管理和分享工作流,让您的朋友也能体验到您的工作流!

工作流模板

工作流模板是由向量脉络团队和社区用户提供的一些常用的工作流程,您可以直接将其添加到您的工作流空间中。

以 官方工作流模板 为例,我们尝试选择 🔀任意语言文章总结生成中文思维导图,在页面中点击添加到我的工作流按钮,即可将该工作流模板添加到您的工作流空间中。

工作流详情

在 我的工作流 页面中,您可以看到您的工作流空间中的所有工作流程。刚刚从工作流模板库中添加的工作流程也会显示在这里。

进入到刚刚添加的工作流里,您可以看到工作流的详细信息,包括名称、简介、标签、更新时间等。如果对添加的工作流有不清楚的地方,您可以点击简介来查看关于该工作流模板的更多详细介绍信息。

从上图的工作流详情页中可以看到,输入和触发器在页面左边,输出在页面的右边。现在尝试运行这个工作流,在网址中填入一篇网络文章的链接,比如:https://sspai.com/post/79916,然后点击运行按钮,等待工作流运行完成。

工作流的运行时长取决于工作流的复杂度。在工作流运行完成后,您可以在输出中看到生成的思维导图以及对应的Markdown格式内容,如下图所示。

如果需要放大输出区域,您可以点击右上角分享输出旁的放大按钮,如下图所示。

对于您满意的工作流,您可以点击右上角的 【分享输出】 按钮开启分享,将工作流的输出结果分享给其他用户。分享的页面如下图所示,可以无需登录查看工作流的输出结果。

📅 工作流运行记录

您的每一个工作流运行过的记录都会被记下来,您可以在工作流详情页右上角的 【工作流运行记录】 按钮中查看工作流的运行记录表格。

对于运行成功的工作流记录,如果点击 【查看记录】 按钮,您可以查看当时工作流的运行记录详情,包括当时的输入输出内容。

而对于运行失败的工作流记录,如果点击 【查看记录及错误任务】 按钮,您可以查看当时工作流运行出错的节点任务是哪一个。

私有化开源版本部署

安装和配置

安装

从 Release 下载 VectorVein 后,程序将在安装目录中创建一个 “data” 文件夹来存储数据库和静态文件资源。

VectorVein 是使用 pywebview 构建的,基于 webview2 内核,因此您需要安装 webview2 运行时。如果无法打开软件,您可能需要从 https://developer.microsoft.com/en-us/microsoft-edge/webview2/ 手动下载 webview2 运行时

配置

软件中的大多数工作流和代理都涉及 AI 大型语言模型的使用,因此您至少应该为大型语言模型提供可用的配置。对于工作流,您可以查看界面中正在使用哪些大型语言模型,如下图所示。

远程大型语言模型接口配置

软件正常开启后,点击设置按钮,在“大型语言模型”选项卡中输入 OpenAI/Moonshot/智谱 AI/Anthropic 的 API Key,即可使用非本地 AI 功能。

本地大型语言模型接口配置

如果使用本地大型语言模型,请在选项卡中填写本地模型配置信息。目前支持 OpenAI 兼容的接口,如 LM-Studio、Ollama、vLLM 等。Local Large Language Model

LM-Studio 的 API 库通常为 http://localhost:1234/v1/

Ollama 的 API 库通常为 http://localhost:11434/v1/

完成配置后,单击 先,然后单击 。

Save Model Family``Save Settings

语音识别配置

目前支持 OpenAI/Deepgram 的语音识别服务。对于 OpenAI 服务,您可以使用与大型语言模型相同的配置,也可以设置与 OpenAI API 兼容的语音识别服务(例如 Groq)。

嵌入配置

当您需要使用矢量数据执行矢量搜索时,您可以选择使用 OpenAI 提供的嵌入服务或在设置中配置本地嵌入服务。目前,受支持的本地嵌入服务要求您自己设置 text-embeddings-inference。Embedding Model

快捷方式设置

为了便于日常使用,您可以配置快捷方式以快速启动与 Agent 的语音对话。通过快捷方式启动,您可以通过语音识别直接与代理交互。请务必确保事先正确配置语音识别服务。

Include Screenshot 表示在开始对话时,将拍摄屏幕的屏幕截图并将其作为对话的附件上传到对话中。

笔记

关于本地 Stable Diffusion API

要使用自己的本地 Stable Diffusion API,需要在 webui-user.bat 的启动项中添加参数 –api,即

1 | set COMMANDLINE_ARGS=--api |

💻 用法

📖 基本概念

工作流表示一个工作任务流程,包括输入、输出以及如何处理输入以达到输出结果。

例子:

- 翻译工作流:输入是英文 Word 文档,输出也是 Word 文档。您可以设计一个工作流来翻译输入的中文文档并生成中文文档输出。

- 思维导图工作流:如果将翻译工作流的输出改为思维导图,则可以获得一个读取英文 Word 文档并将其总结成中文思维导图的工作流。

- Web 文章摘要工作流:如果将思维导图工作流的输入更改为 Web 文章的 URL,则可以获得一个读取 Web 文章并将其汇总成中文思维导图的工作流。

- 客户投诉自动分类工作流:输入是包含投诉内容的表格,您可以自定义需要分类的关键词,以便投诉自动分类。输出是自动生成的包含分类结果的 Excel 表。

🔎 用户界面

每个工作流都有一个用户界面和一个编辑器界面。用户界面用于日常工作流操作,编辑器界面用于工作流编辑。通常,设计完工作流后,您只需在用户界面中运行即可,无需在编辑器界面中进行修改。

用户界面如上所示,分为三个部分:输入、输出和触发器(通常是一个运行按钮)。可以直接输入日常使用的内容,点击运行按钮即可查看输出结果。

要查看已执行的工作流,请单击 工作流运行记录,如下图所示。

✏️ 创建工作流

您可以将我们的官方模板添加到您的工作流程中或创建一个新模板。建议在开始时使用官方模板熟悉工作流程的使用。

工作流编辑器界面如上所示。您可以在顶部编辑名称、标签和详细说明。左侧是工作流的节点列表,右侧是工作流的画布。你可以将想要的节点从左侧拖拽到画布上,然后通过电线连接节点,形成一个工作流。

您可以在此处查看有关创建简单爬虫 + AI 摘要思维导图工作流程的教程。

您也可以尝试此在线交互式教程。

🛠️ 开发和部署

环境要求

- 后端

- Python 3.8 ~ Python 3.11

- 已安装 PDM

- 前端

- 视图3

- 迅速

项目开发

在 backend 目录下执行以下命令,安装依赖。

窗户

1 | pdm install |

苹果电脑

1 | pdm install -G mac |

通常,PDM 会自动找到系统的 Python 并创建虚拟环境并安装依赖项。

安装完成后,执行以下命令启动后端开发服务器,查看运行效果。

1 | pdm run dev |

如果需要修改前端代码,需要在前端目录下执行以下命令安装依赖:

1 | pnpm install |

第一次拉取项目代码时,还需要运行安装前端依赖。

pnpm install如果根本不需要开发任何前端代码,可以直接将 release 版本的文件夹复制到该文件夹中。

web``backend

前端依赖安装完成后,您需要将前端代码编译到后端的静态文件目录中。项目中提供了快捷方式说明。在 backend 目录下执行以下命令,打包并复制前端资源。

1 | pdm run build-front |

软件打包

该项目使用 pyinstaller 进行打包。在 backend 目录下执行以下命令,将其打包成可执行文件。

1 | pdm run build |

打包后,会在backend/dist 目录下生成可执行文件。